Que vaut un référentiel de compétences sans des critères d’évaluation clairs et partagés ? Dans cet article, nous explorons les clés pour définir des critères efficaces, mesurables et utiles à la fois pour les formateurs… et pour les apprenants.

1. L’enjeu crucial des critères d’évaluation

1.1 Du référentiel de compétences à l’évaluation concrète

Dans les deux premiers articles de notre série, nous avons exploré les fondamentaux d’un référentiel de compétences solide et les méthodes de co-construction impliquant toutes les parties prenantes. Ces étapes essentielles ont permis de définir précisément les compétences visées par votre formation. Mais une question fondamentale se pose désormais : comment évaluer objectivement et efficacement l’acquisition de ces compétences par les apprenants ?

C’est ici qu’intervient l’élaboration des critères d’évaluation, véritable pont entre l’intention pédagogique (la compétence visée) et sa manifestation observable (la performance de l’apprenant). Sans critères pertinents et opérationnels, même le référentiel le mieux conçu risque de rester lettre morte, faute d’outils pour mesurer concrètement la progression des apprenants.

Exemple concret : Un organisme de formation en management avait élaboré un référentiel de compétences ambitieux et bien structuré. Cependant, des critères d’évaluation trop vagues comme « Communication efficace » ou « Bonne gestion d’équipe » ont conduit à des évaluations très hétérogènes selon les formateurs. Certains validaient la compétence sur la base de connaissances théoriques, d’autres exigeaient une démonstration en situation réelle, créant confusion et sentiment d’injustice chez les apprenants.

1.2 Les défis spécifiques de l’évaluation par compétences

L’évaluation par compétences présente des défis particuliers qui la distinguent des approches traditionnelles centrées sur les connaissances :

La complexité des compétences

Par définition, une compétence implique la mobilisation combinée de divers savoirs, savoir-faire et attitudes dans des situations complexes et souvent inédites. Comment évaluer cette mobilisation intégrée sans la réduire à ses composantes isolées ?

Exemple concret : Dans une formation d’assistants de service social, la compétence « Conduire un entretien d’aide avec une personne en situation de précarité » implique simultanément des connaissances (cadre réglementaire, dispositifs d’aide), des savoir-faire techniques (techniques d’entretien, écoute active) et des savoir-être (empathie, non-jugement). Évaluer isolément chaque dimension ne permet pas de saisir la compétence dans sa globalité.

L’authenticité des situations d’évaluation

Pour juger réellement d’une compétence, il faut l’observer dans des situations aussi proches que possible des contextes professionnels réels, ce qui soulève des questions logistiques et méthodologiques.

Exemple concret : Une école de commerce avait initialement évalué la compétence « Négocier un contrat commercial » à travers un QCM et un cas écrit. Face aux retours des entreprises sur le décalage entre validation académique et performance réelle, l’établissement a dû repenser son approche pour intégrer des mises en situation filmées avec des acteurs professionnels jouant le rôle de clients difficiles. Cette évolution a considérablement amélioré la pertinence de l’évaluation, mais a aussi complexifié son organisation.

L’objectivité et l’équité

Comment garantir que différents évaluateurs jugent de façon similaire une même performance, surtout lorsqu’il s’agit de compétences comportant une dimension subjective ?

Exemple concret : Dans un CFA du secteur de la restauration, l’évaluation de la compétence « Dresser une assiette selon les standards gastronomiques » montrait des écarts significatifs entre évaluateurs : certains chefs privilégiaient l’esthétique, d’autres l’efficacité technique, d’autres encore l’originalité. Cette variabilité créait un sentiment d’arbitraire chez les apprentis.

La dimension développementale

L’évaluation des compétences n’est pas qu’un jugement final (sommatif), mais aussi un outil de progression (formatif). Comment concevoir des critères qui favorisent l’auto-évaluation et orientent efficacement le développement de l’apprenant ?

Exemple concret : Une formation d’éducateurs spécialisés a transformé ses grilles d’évaluation pour y intégrer systématiquement trois dimensions : les points maîtrisés, les axes de progression prioritaires et les stratégies concrètes de développement. Ce changement a modifié la perception de l’évaluation, désormais vue comme un levier d’amélioration plutôt que comme un simple jugement.

Face à ces défis, l’élaboration de critères d’évaluation pertinents, mesurables et équitables constitue un art à part entière, qui nécessite à la fois une méthodologie rigoureuse et une approche pragmatique.

2. Définir des critères d’évaluation précis et mesurables

2.1 Les caractéristiques essentielles d’un bon critère d’évaluation

Pour être véritablement opérationnels, les critères d’évaluation doivent répondre à plusieurs exigences fondamentales :

Observable et mesurable

Un critère efficace décrit un comportement ou un résultat que l’évaluateur peut observer directement, sans interprétation excessive.

Bon critère : « L’apprenant maintient un contact visuel avec son interlocuteur pendant au moins 70% de la durée de l’entretien »Critère problématique : « L’apprenant fait preuve d’attention envers son interlocuteur »

Le premier critère décrit un comportement précis et quantifiable, tandis que le second reste trop abstrait pour permettre une observation objective.

Univoque

Le critère doit être compris de la même façon par tous les acteurs concernés (différents évaluateurs, apprenants, etc.), limitant ainsi les variations d’interprétation.

Bon critère : « Le rapport contient une analyse chiffrée des résultats incluant au minimum 3 indicateurs pertinents »Critère problématique : « Le rapport présente une bonne analyse des résultats »

L’adjectif « bonne » est sujet à interprétation, tandis que la mention d’éléments précis (analyse chiffrée, minimum 3 indicateurs) réduit considérablement la subjectivité.

Pertinent

Le critère doit se concentrer sur des éléments qui constituent des indicateurs fiables de la maîtrise de la compétence évaluée.

Bon critère (pour évaluer la compétence « Élaborer un plan de communication digitale ») : « La stratégie proposée identifie clairement les canaux digitaux adaptés à la cible définie et justifie ces choix par des données d’audience »Critère non pertinent : « Le document respecte les règles orthographiques et grammaticales »

Bien que la correction linguistique soit importante, elle ne constitue pas un indicateur spécifique de la compétence en stratégie digitale. Un tel critère pourrait figurer dans une évaluation transversale des compétences rédactionnelles, mais pas comme critère principal d’une compétence métier.

Hiérarchisé

Dans la mesure du possible, le critère devrait permettre d’identifier différents niveaux de maîtrise, plutôt qu’une simple validation binaire (acquis/non acquis).

Critère hiérarchisé : « Qualité de l’argumentation commerciale », avec les niveaux suivants :

- Niveau 1 : Arguments génériques, non adaptés à l’interlocuteur

- Niveau 2 : Arguments pertinents mais présentation mécanique, sans adaptation aux réactions

- Niveau 3 : Arguments personnalisés et ajustés en fonction des objections et réactions de l’interlocuteur

- Niveau 4 : Argumentaire stratégique qui anticipe les objections et guide progressivement vers la décision

Cette approche graduée offre une vision plus fine du développement de la compétence et permet d’identifier précisément les axes de progression.

Réalisable

Le critère doit pouvoir être évalué dans les conditions réelles de la formation, avec les ressources et le temps disponibles.

Exemple concret : Dans une formation en management de projet, un critère initialement défini comme « Capacité à gérer un projet de A à Z avec succès » s’est avéré impossible à évaluer dans le cadre temporel d’un module de formation. Il a été remplacé par plusieurs critères plus spécifiques et observables dans le cadre d’un projet simulé : « Élaboration d’un planning réaliste respectant les contraintes données », « Identification et évaluation des risques principaux », « Mise en place d’un tableau de bord de suivi avec indicateurs pertinents », etc.

2.2 L’utilisation des taxonomies d’apprentissage

Pour structurer efficacement vos critères d’évaluation, les taxonomies d’apprentissage constituent des outils précieux. Elles offrent un cadre conceptuel pour graduer les niveaux d’exigence et assurer une progression cohérente.

La taxonomie de Bloom révisée

La taxonomie de Bloom révisée par Anderson et Krathwohl (2001) définit six niveaux cognitifs de complexité croissante :

- Se souvenir : reconnaître, rappeler des informations

- Comprendre : interpréter, exemplifier, classifier, résumer, comparer, expliquer

- Appliquer : exécuter, mettre en œuvre dans des situations concrètes

- Analyser : différencier, organiser, attribuer, déconstruire

- Évaluer : vérifier, critiquer, juger sur la base de critères

- Créer : générer, planifier, produire quelque chose de nouveau

Exemple d’application : Pour la compétence « Analyser un marché pour élaborer une stratégie commerciale », on peut définir des critères progressifs selon les niveaux de Bloom :

- Niveau 2 (Comprendre) : « L’apprenant explique les principaux facteurs d’influence du marché étudié »

- Niveau 3 (Appliquer) : « L’apprenant utilise les outils d’analyse de marché appropriés pour collecter des données pertinentes »

- Niveau 4 (Analyser) : « L’apprenant identifie les segments de marché et leurs caractéristiques distinctives »

- Niveau 5 (Évaluer) : « L’apprenant évalue la pertinence des opportunités identifiées en fonction des ressources de l’entreprise »

- Niveau 6 (Créer) : « L’apprenant élabore une stratégie commerciale innovante et adaptée aux spécificités du marché analysé »

Cette progression permet d’adapter les critères d’évaluation au niveau attendu dans le parcours de formation, tout en gardant une cohérence globale.

La taxonomie de Dave pour le domaine psychomoteur

Pour les compétences impliquant des gestes techniques ou des habiletés manuelles, la taxonomie de Dave (1970) propose cinq niveaux :

- Imitation : observer et reproduire sous supervision

- Manipulation : exécuter selon des instructions, avec une certaine autonomie

- Précision : reproduire un geste avec exactitude et sans aide

- Articulation : coordonner une séquence d’actions avec fluidité

- Naturalisation : exécuter avec expertise, automatisme et adaptabilité

Exemple d’application : Pour la compétence « Réaliser une prise de sang » dans une formation d’infirmiers :

- Niveau 1 (Imitation) : « L’apprenant reproduit correctement le geste sur un mannequin sous supervision directe »

- Niveau 2 (Manipulation) : « L’apprenant prépare le matériel adéquat et réalise la procédure sur mannequin en autonomie »

- Niveau 3 (Précision) : « L’apprenant réalise le geste technique avec précision, en respectant chaque étape du protocole »

- Niveau 4 (Articulation) : « L’apprenant coordonne efficacement l’ensemble de la procédure, de la préparation à la finalisation, même dans des situations complexes (veines difficiles) »

- Niveau 5 (Naturalisation) : « L’apprenant réalise le prélèvement avec aisance tout en gérant la relation au patient et en s’adaptant à des situations imprévues »

La taxonomie de Krathwohl pour le domaine affectif

Pour les compétences comportant une dimension relationnelle, émotionnelle ou éthique, la taxonomie de Krathwohl offre cinq niveaux :

- Réception : être attentif, conscient d’une situation

- Réponse : réagir, participer activement

- Valorisation : attacher de l’importance, montrer un engagement

- Organisation : intégrer des valeurs dans un système cohérent

- Caractérisation : agir systématiquement selon des valeurs intégrées

Exemple d’application : Pour la compétence « Accompagner une personne en fin de vie » dans une formation d’aides-soignants :

- Niveau 1 (Réception) : « L’apprenant identifie les besoins spécifiques exprimés par la personne en fin de vie »

- Niveau 2 (Réponse) : « L’apprenant adapte ses gestes et sa communication en fonction de l’état du patient »

- Niveau 3 (Valorisation) : « L’apprenant fait preuve d’empathie authentique et de respect pour les choix et croyances du patient »

- Niveau 4 (Organisation) : « L’apprenant concilie les exigences techniques des soins avec le respect de la dignité et du confort psychologique du patient »

- Niveau 5 (Caractérisation) : « L’apprenant intègre naturellement la dimension éthique dans l’ensemble de sa pratique professionnelle, y compris dans des situations complexes »

L’utilisation de ces taxonomies permet de structurer les critères d’évaluation selon une progression logique et cohérente, tout en couvrant les différentes dimensions de la compétence (cognitive, psychomotrice, affective).

2.3 Les différents types de critères selon leur fonction

Au-delà des taxonomies, il est utile de distinguer plusieurs types de critères selon leur fonction dans l’évaluation :

Critères de réalisation

Ils décrivent les conditions dans lesquelles la compétence doit être démontrée pour être considérée comme acquise.

Exemples :

- « En utilisant exclusivement les outils disponibles dans un contexte professionnel standard »

- « Dans un délai maximum de 45 minutes »

- « Face à un client simulé présentant des objections prédéfinies »

- « En situation de stress simulé (interruptions, contrainte temporelle) »

Ces critères permettent de contextualiser l’évaluation et de la rapprocher des conditions réelles d’exercice de la compétence.

Critères de performance

Ils définissent le niveau de qualité attendu dans la réalisation.

Exemples :

- « Sans erreur dans les calculs budgétaires »

- « Avec un taux d’adhésion d’au moins 80% des membres de l’équipe »

- « En générant au minimum trois propositions créatives distinctes »

- « Avec un niveau de satisfaction client d’au moins 4/5 »

Ces critères établissent des standards objectifs qui permettent de juger de la qualité de la performance.

Critères de résultat

Ils se focalisent sur le produit final ou l’effet obtenu, indépendamment de la méthode utilisée.

Exemples :

- « Le prototype fonctionne conformément au cahier des charges »

- « Le texte produit est compréhensible par un lecteur non-spécialiste »

- « La solution proposée résout le problème initial »

- « Le conflit est désamorcé et une solution acceptable par les deux parties est trouvée »

Ces critères sont particulièrement adaptés aux compétences où plusieurs approches peuvent être valables pour atteindre un même objectif.

Critères de démarche

Ils s’attachent au processus, à la méthodologie employée plutôt qu’au résultat.

Exemples :

- « La méthode d’analyse suit les étapes du protocole scientifique établi »

- « Le processus de diagnostic respecte l’ordre logique : observation, hypothèses, vérification »

- « L’approche du problème est structurée et documentée à chaque étape »

- « La démarche inclut une phase d’analyse des risques préalable à l’action »

Ces critères sont essentiels pour les compétences où la rigueur méthodologique est aussi importante que le résultat lui-même.

2.4 Méthodes pratiques pour élaborer des critères pertinents

Plusieurs approches méthodologiques peuvent vous aider à formuler des critères d’évaluation pertinents et opérationnels :

L’analyse de l’activité professionnelle

Cette méthode consiste à observer et analyser finement comment les professionnels expérimentés exercent la compétence dans des situations réelles, pour en déduire des indicateurs observables de performance.

Exemple concret : Pour élaborer les critères d’évaluation de la compétence « Conduire un entretien de vente », un organisme de formation a filmé puis analysé 20 entretiens menés par des commerciaux performants. Cette analyse a permis d’identifier des comportements récurrents qui différenciaient clairement les professionnels efficaces : utilisation de questions ouvertes en phase de découverte, reformulation des besoins avant proposition, traitement méthodique des objections, conclusion par une proposition d’action concrète. Ces comportements observables ont été traduits en critères d’évaluation précis.

La méthode SMART

Bien connue dans le management, la méthode SMART peut être adaptée à la formulation des critères d’évaluation :

- Spécifique : le critère cible précisément un aspect de la compétence

- Mesurable : il permet une observation objective

- Atteignable : il correspond à un niveau d’exigence réaliste

- Réaliste : il peut être évalué dans les conditions de la formation

- Temporel : il précise, si pertinent, les contraintes de temps

Exemple d’application : Pour la compétence « Animer une réunion d’équipe efficace », un critère formulé selon la méthode SMART pourrait être : « L’apprenant produit et diffuse un ordre du jour structuré au moins 48h avant la réunion, incluant les objectifs, les points à traiter, la durée prévue pour chaque point et les participants concernés. »

La coconstruction avec les apprenants

Impliquer les apprenants dans l’élaboration des critères d’évaluation présente plusieurs avantages : meilleure compréhension des attentes, engagement accru, développement de compétences métacognitives.

Exemple concret : Dans un Master en management de projet, les étudiants contribuent à l’élaboration des critères d’évaluation du projet de fin d’études. Après présentation du référentiel de compétences, ils travaillent en groupes pour proposer des critères concrets permettant d’évaluer ces compétences. Ces propositions sont ensuite discutées collectivement, affinées avec l’aide des enseignants, puis intégrées à la grille d’évaluation finale. Cette approche a significativement amélioré la compréhension des attentes et l’auto-évaluation des étudiants.

La méthode des incidents critiques

Cette approche consiste à identifier, à partir de situations professionnelles problématiques ou particulièrement réussies, les comportements qui font la différence entre réussite et échec.

Exemple concret : Dans une formation d’éducateurs spécialisés, l’équipe pédagogique a collecté auprès de professionnels expérimentés des récits de situations critiques (gestion de crise, accompagnement d’un cas difficile, résolution d’un conflit). L’analyse de ces récits a permis d’identifier les comportements déterminants dans la gestion réussie de ces situations : capacité à maintenir une communication non violente sous stress, mobilisation adaptée des ressources institutionnelles, prise de recul face à ses propres émotions, etc. Ces comportements ont été traduits en critères d’évaluation précis pour les mises en situation simulées.

3. Les outils d’évaluation adaptés à l’approche par compétences

Une fois les critères définis, il faut les intégrer dans des outils d’évaluation adaptés. L’approche par compétences nécessite souvent de repenser les méthodes d’évaluation traditionnelles pour privilégier des formats plus authentiques et intégrateurs.

3.1 Les grilles d’évaluation critériées

Les grilles d’évaluation constituent l’outil central de l’évaluation par compétences. Elles permettent de structurer l’observation et le jugement selon les critères préalablement définis.

Les rubriques (ou grilles analytiques)

Ces grilles détaillent chaque critère et définissent précisément les niveaux de performance pour chacun d’eux.

Exemple de rubrique pour la compétence « Concevoir une interface utilisateur » :

Critère | Insuffisant (1) | En développement (2) | Maîtrisé (3) | Expert (4) |

Diversité des preuves | Portfolio incomplet, ne couvrant pas toutes les compétences | Preuves présentes pour chaque compétence mais peu variées | Variété pertinente de preuves pour chaque compétence | Large éventail de preuves issues de contextes variés pour chaque compétence |

Qualité des réalisations | Productions de qualité insuffisante ou ne démontrant pas les compétences visées | Productions de qualité acceptable démontrant partiellement les compétences | Productions de bonne qualité démontrant clairement les compétences | Productions exemplaires démontrant une maîtrise experte des compétences |

Analyse réflexive | Absence d’analyse ou réflexion superficielle | Réflexion présente mais descriptive plus qu’analytique | Analyse pertinente des forces et faiblesses, avec pistes d’amélioration | Réflexion approfondie intégrant théorie et pratique, avec stratégies d’amélioration concrètes |

Évolution et progression | Aucune évidence de progression | Progression visible mais limitée ou inégale selon les compétences | Progression claire et documentée pour l’ensemble des compétences | Transformation significative démontrée par des preuves chronologiques pour chaque compétence |

3.4 L’évaluation par les pairs et l’auto-évaluation

Pour développer la capacité d’auto-régulation des apprenants et enrichir le processus d’évaluation, l’évaluation par les pairs et l’auto-évaluation constituent des compléments précieux aux évaluations par les formateurs.

L’auto-évaluation structurée

L’auto-évaluation devient un véritable outil de développement lorsqu’elle est structurée par les mêmes critères que l’évaluation formelle.

Exemple concret : Dans une formation de développeurs web, avant chaque évaluation formelle d’un projet, les apprenants complètent une grille d’auto-évaluation identique à celle qu’utilisera l’évaluateur. Cette grille détaille les critères techniques (fonctionnalité, performance, sécurité) et méthodologiques (organisation du code, documentation, tests). Lors de l’entretien d’évaluation, l’apprenant commence par présenter son auto-évaluation, puis le formateur partage la sienne. Les écarts sont analysés collectivement, créant ainsi une opportunité d’apprentissage métacognitif.

L’évaluation par les pairs

Cette approche enrichit le feedback reçu tout en développant les compétences évaluatives des apprenants eux-mêmes.

Exemple concret : Dans un Master en communication, les présentations orales sont systématiquement évaluées par trois acteurs : le formateur, l’apprenant lui-même, et deux pairs. Tous utilisent la même grille critériée (structure, argumentation, supports visuels, expression orale, gestion du temps). Les évaluateurs pairs doivent justifier leurs appréciations par des observations factuelles et des suggestions d’amélioration constructives. Cette triple évaluation a non seulement enrichi le feedback reçu par chaque étudiant, mais a également développé leur capacité critique et analytique.

Les conditions de réussite

Pour être véritablement efficaces, ces approches nécessitent plusieurs conditions :

- Formation préalable aux techniques d’évaluation et aux critères spécifiques

- Climat de confiance favorisant l’honnêteté et la bienveillance

- Grilles d’évaluation précises limitant la subjectivité

- Mécanismes de modération en cas d’écarts significatifs

- Intégration explicite dans le processus global d’évaluation et de développement

4. Tester et ajuster en continu les critères d’évaluation

Même les critères d’évaluation les mieux conçus ne peuvent être considérés comme définitifs. Leur pertinence et leur efficacité doivent être régulièrement testées et ajustées.

4.1 Le test pilote : une étape incontournable

Avant de généraliser l’utilisation de nouveaux critères d’évaluation, une phase de test sur un échantillon limité est essentielle pour identifier et corriger les problèmes potentiels.

Méthodologie du test pilote

Un test pilote efficace comprend plusieurs étapes clés :

- Sélection d’un échantillon représentatif (un groupe d’apprenants, un module spécifique)

- Formation des évaluateurs aux nouveaux critères et outils

- Application parallèle des anciens et nouveaux critères pour comparaison

- Recueil systématique des retours de toutes les parties prenantes

- Analyse des résultats et identification des ajustements nécessaires

Exemple concret : Un institut de formation en soins infirmiers a testé ses nouvelles grilles d’évaluation de stage sur deux promotions parallèles avant généralisation. Durant cette phase pilote, les tuteurs de stage ont utilisé simultanément l’ancienne et la nouvelle grille. Une analyse comparative des résultats a révélé que certains critères de la nouvelle grille généraient des interprétations très variables selon les évaluateurs. Des sessions d’harmonisation ont été organisées, et les critères problématiques ont été reformulés ou accompagnés d’exemples concrets pour guider les évaluateurs. Le taux de concordance inter-évaluateurs s’est significativement amélioré après ces ajustements.

Indicateurs de qualité à surveiller

Plusieurs indicateurs permettent de juger de la qualité des critères d’évaluation :

- Concordance inter-évaluateurs : différents évaluateurs obtiennent-ils des résultats similaires face à une même performance ?

- Cohérence interne : les différents critères évaluant des aspects liés d’une même compétence montrent-ils des résultats cohérents ?

- Validité perçue : les apprenants et les formateurs reconnaissent-ils la pertinence des critères par rapport à la compétence visée ?

- Capacité discriminante : les critères permettent-ils de distinguer différents niveaux de maîtrise ?

- Faisabilité pratique : le temps et les ressources nécessaires à l’évaluation sont-ils raisonnables ?

4.2 La collecte de feedbacks multiples

Pour garantir la pertinence et l’acceptabilité des critères d’évaluation, il est essentiel de recueillir les retours de toutes les parties prenantes.

Les apprenants : premiers concernés

Les apprenants peuvent fournir des insights précieux sur la clarté, la pertinence et l’effet motivationnel des critères d’évaluation.

Exemple concret : Une école de design a mis en place un rituel de « revue des critères » après chaque session d’évaluation majeure. Les étudiants sont invités à commenter anonymement la clarté, la pertinence et l’équité des critères utilisés, ainsi qu’à suggérer des améliorations. Ce feedback a conduit à plusieurs ajustements significatifs, notamment l’ajout d’exemples concrets pour illustrer chaque niveau de performance et la reformulation de critères jugés trop subjectifs. Les étudiants ont rapporté une meilleure compréhension des attentes et une perception accrue de justice évaluative.

Les formateurs et évaluateurs : experts de terrain

Ceux qui appliquent les critères au quotidien sont les mieux placés pour identifier les difficultés pratiques d’utilisation.

Exemple concret : Dans un CFA du bâtiment, après six mois d’utilisation des nouvelles grilles d’évaluation, un questionnaire a été envoyé à tous les formateurs et maîtres d’apprentissage. Les retours ont mis en évidence une difficulté majeure : certains critères techniques étaient trop détaillés pour être évalués en situation réelle de chantier. Le référentiel a été ajusté pour proposer des critères plus synthétiques pour les évaluations en entreprise, tout en conservant le détail pour les évaluations en centre de formation.

Les employeurs et partenaires professionnels : garants de la pertinence

Leur perspective est essentielle pour garantir l’alignement entre l’évaluation formative et les exigences du monde professionnel.

Exemple concret : Un Master en marketing digital réunit annuellement son conseil de perfectionnement composé d’employeurs partenaires. Lors d’une de ces réunions, les professionnels ont signalé que les critères d’évaluation des compétences en analyse de données mettaient trop l’accent sur la maîtrise technique des outils, au détriment de la capacité à traduire les insights en recommandations business concrètes. Suite à ce retour, une nouvelle rubrique « Pertinence business des recommandations » a été ajoutée à la grille d’évaluation, reflétant mieux les attentes des employeurs.

4.3 L’ajustement méthodique des critères

Sur la base des retours collectés et des observations réalisées, les critères d’évaluation doivent être régulièrement affinés selon un processus méthodique.

Types d’ajustements fréquents

Plusieurs types de modifications peuvent s’avérer nécessaires :

- Reformulation pour clarifier des critères ambigus ou prêtant à interprétation

- Recalibrage des niveaux de performance pour mieux refléter la réalité du terrain

- Pondération ajustée pour mieux refléter l’importance relative des différents critères

- Ajout d’exemples concrets pour illustrer chaque niveau de performance

- Suppression ou fusion de critères redondants ou difficiles à évaluer en pratique

- Ajout de critères pour couvrir des dimensions importantes initialement négligées

Exemple concret : Dans une formation de managers, après un cycle complet d’utilisation, la grille d’évaluation de la compétence « Conduire un entretien annuel » a fait l’objet de plusieurs ajustements :

- Le critère « Qualité de l’écoute » a été reformulé en comportements observables : « Laisse l’interlocuteur s’exprimer sans interruption », « Reformule les points clés pour vérifier sa compréhension »

- Les niveaux de performance du critère « Fixation d’objectifs » ont été recalibrés car trop exigeants par rapport à la réalité professionnelle

- La pondération du critère « Préparation de l’entretien » a été augmentée suite aux retours des professionnels soulignant son importance critique

- Des exemples concrets ont été ajoutés pour chaque niveau du critère « Gestion des émotions » jugé trop abstrait

- Deux critères sur le suivi administratif ont été fusionnés pour simplifier l’évaluation

- Un nouveau critère « Adaptation à la personnalité du collaborateur » a été ajouté suite aux retours des apprenants expérimentés

Documentation des évolutions

Pour garantir la traçabilité et faciliter l’appropriation des ajustements, il est essentiel de documenter soigneusement les modifications apportées.

Exemple concret : Une école d’ingénieurs a mis en place un « journal d’évolution du référentiel » accessible à tous les formateurs. Pour chaque modification de critère, ce journal précise :

- La formulation initiale et la nouvelle formulation

- La justification du changement (retours spécifiques, données d’évaluation)

- La date d’application et les modalités de transition

- Les implications pour les évaluations déjà réalisées ou en cours

Ce système a considérablement facilité l’adaptation des équipes pédagogiques aux évolutions du référentiel et a créé une culture d’amélioration continue des pratiques d’évaluation.

4.4 L’exemple du CFA en énergies renouvelables

Pour illustrer concrètement ce processus d’ajustement continu, examinons le cas d’un Centre de Formation d’Apprentis spécialisé dans les métiers des énergies renouvelables.

Contexte initial

Ce CFA a lancé une nouvelle formation de « Technicien en installation et maintenance de systèmes photovoltaïques », avec un référentiel de compétences développé en collaboration avec des professionnels du secteur. Pour la compétence clé « Mise en service d’une installation photovoltaïque », une première grille d’évaluation a été élaborée avec 8 critères techniques et 3 critères relatifs à la sécurité.

Phase de test

Pendant les trois premiers mois, cette grille a été utilisée par les formateurs du CFA et par quelques maîtres d’apprentissage volontaires. Rapidement, plusieurs problèmes ont émergé :

- Certains critères techniques étaient trop détaillés pour être évalués facilement en situation réelle

- Les niveaux de performance n’étaient pas suffisamment distinctifs

- La dimension « relation client » était absente alors qu’elle s’avérait cruciale en situation professionnelle

- Les maîtres d’apprentissage trouvaient la grille trop complexe à utiliser

Collecte de feedbacks

Le CFA a organisé une collecte structurée de retours via :

- Un questionnaire en ligne adressé à tous les évaluateurs

- Un focus group avec 6 apprentis

- Des entretiens individuels avec 4 maîtres d’apprentissage

- Une réunion d’analyse avec l’équipe pédagogique

Ajustements réalisés

Sur la base de ces retours, plusieurs modifications ont été apportées :

- Simplification des critères techniques : regroupement en 5 critères synthétiques plus faciles à évaluer

- Redéfinition des niveaux de performance : passage de 3 à 4 niveaux avec des descripteurs plus précis

- Ajout d’une dimension « relation client » avec 2 critères spécifiques

- Création de deux versions de la grille : une version détaillée pour le CFA et une version simplifiée pour les entreprises

- Élaboration d’un guide d’utilisation avec exemples concrets pour chaque niveau de performance

Validation et généralisation

Après ces ajustements, la nouvelle grille a été testée pendant deux mois supplémentaires, puis validée définitivement. Un suivi régulier a été mis en place :

- Réunion semestrielle d’harmonisation entre évaluateurs

- Collecte annuelle des retours de toutes les parties prenantes

- Mise à jour régulière pour intégrer les évolutions technologiques du secteur

Cette démarche itérative a permis d’aboutir à un dispositif d’évaluation à la fois rigoureux et pragmatique, bien adapté aux réalités du terrain et approprié par l’ensemble des acteurs.

5. Vers une évaluation au service du développement des compétences

Au-delà des aspects méthodologiques, il est essentiel de rappeler que l’évaluation par critères n’est pas une fin en soi, mais un moyen de favoriser le développement des compétences.

5.1 L’évaluation comme levier d’apprentissage

L’approche par critères, lorsqu’elle est bien conçue, transforme l’évaluation d’un simple jugement en un puissant levier d’apprentissage.

La dimension formative des critères

Des critères bien formulés constituent en eux-mêmes une ressource pédagogique qui oriente l’apprentissage et l’auto-régulation.

Exemple concret : Une école d’ingénieurs a constaté que la simple distribution des grilles critériées en début de projet avait considérablement amélioré la qualité des travaux rendus. Les étudiants utilisaient spontanément les critères comme un guide de travail, vérifiant régulièrement leur progression. L’établissement a alors développé des « versions apprentissage » de ses grilles, incluant pour chaque critère des ressources d’aide et des exercices d’autodiagnostic.

Le feedback critérié

L’évaluation basée sur des critères explicites permet un feedback précis et actionnable, bien plus utile qu’une simple note ou un commentaire général.

Exemple concret : Dans une formation de consultants, chaque simulation d’intervention est évaluée via une grille détaillée. Le feedback post-évaluation est structuré en trois temps :

- Points forts (critères les mieux maîtrisés)

- Axes prioritaires de développement (critères les moins bien maîtrisés)

- Stratégies concrètes de progression pour chaque axe

Cette approche a transformé la perception de l’évaluation, désormais vécue comme une opportunité de développement professionnel plutôt que comme un jugement anxiogène.

5.2 L’intégration dans une démarche globale de développement des compétences

Pour maximiser son impact, l’évaluation par critères doit s’inscrire dans une démarche globale et cohérente.

L’alignement pédagogique

Les critères d’évaluation doivent être en parfaite cohérence avec les objectifs d’apprentissage et les activités pédagogiques proposées.

Exemple concret : Un institut de formation en management a réorganisé l’ensemble de son approche pédagogique selon le principe d’alignement constructif (Biggs) :

- Définition précise des compétences visées (référentiel)

- Formulation des critères d’évaluation pour chaque compétence

- Conception d’activités pédagogiques permettant de développer spécifiquement ces compétences

- Organisation d’évaluations formatives régulières basées sur les mêmes critères

Cette approche intégrée a considérablement renforcé la cohérence du parcours et amélioré les taux de réussite aux évaluations certificatives.

La progression des exigences

Les critères d’évaluation doivent évoluer tout au long du parcours de formation pour refléter la progression attendue des apprenants.

Exemple concret : Une école de journalisme a développé des grilles d’évaluation évolutives pour la compétence « Rédaction d’un article d’information » :

- En 1ère année : l’accent est mis sur les critères de base (structure pyramidale, réponse aux 5W, correction linguistique)

- En 2ème année : les critères se complexifient (angle original, qualité des sources, style journalistique)

- En 3ème année : des critères avancés sont introduits (impact éditorial, dimension multimédia, adaptation aux différents supports)

Cette progression explicite des exigences permet aux étudiants de visualiser clairement leur parcours de développement sur trois ans.

L’implication des apprenants dans leur propre évaluation

Pour maximiser l’impact formatif, les apprenants doivent être activement impliqués dans le processus d’évaluation.

Exemple concret : Un Master en management de l’innovation a mis en place un dispositif complet d’implication des étudiants :

- Participation à l’élaboration des critères en début de module

- Auto-évaluation systématique avant chaque évaluation formelle

- Contrat de progression personnalisé basé sur l’analyse des écarts

- Portfolio de compétences documentant les progrès réalisés

- Évaluation par les pairs lors des projets collectifs

Ce dispositif a considérablement renforcé l’engagement des étudiants et leur capacité d’auto-régulation, compétence essentielle dans leur futur contexte professionnel.

Conclusion : Des critères vivants pour une évaluation authentique

L’élaboration de critères d’évaluation pertinents, mesurables et justes constitue un défi majeur dans la mise en œuvre d’une approche par compétences. Comme nous l’avons vu tout au long de cet article, il ne s’agit pas d’un exercice théorique ou administratif, mais d’une démarche fondamentalement pédagogique qui influence profondément l’expérience d’apprentissage.

Les critères d’évaluation ne sont pas de simples outils de mesure ; ils constituent de véritables boussoles qui orientent tant l’enseignement que l’apprentissage. Lorsqu’ils sont bien conçus, explicites et partagés, ils transforment l’évaluation d’une source potentielle d’anxiété en un levier puissant de développement.

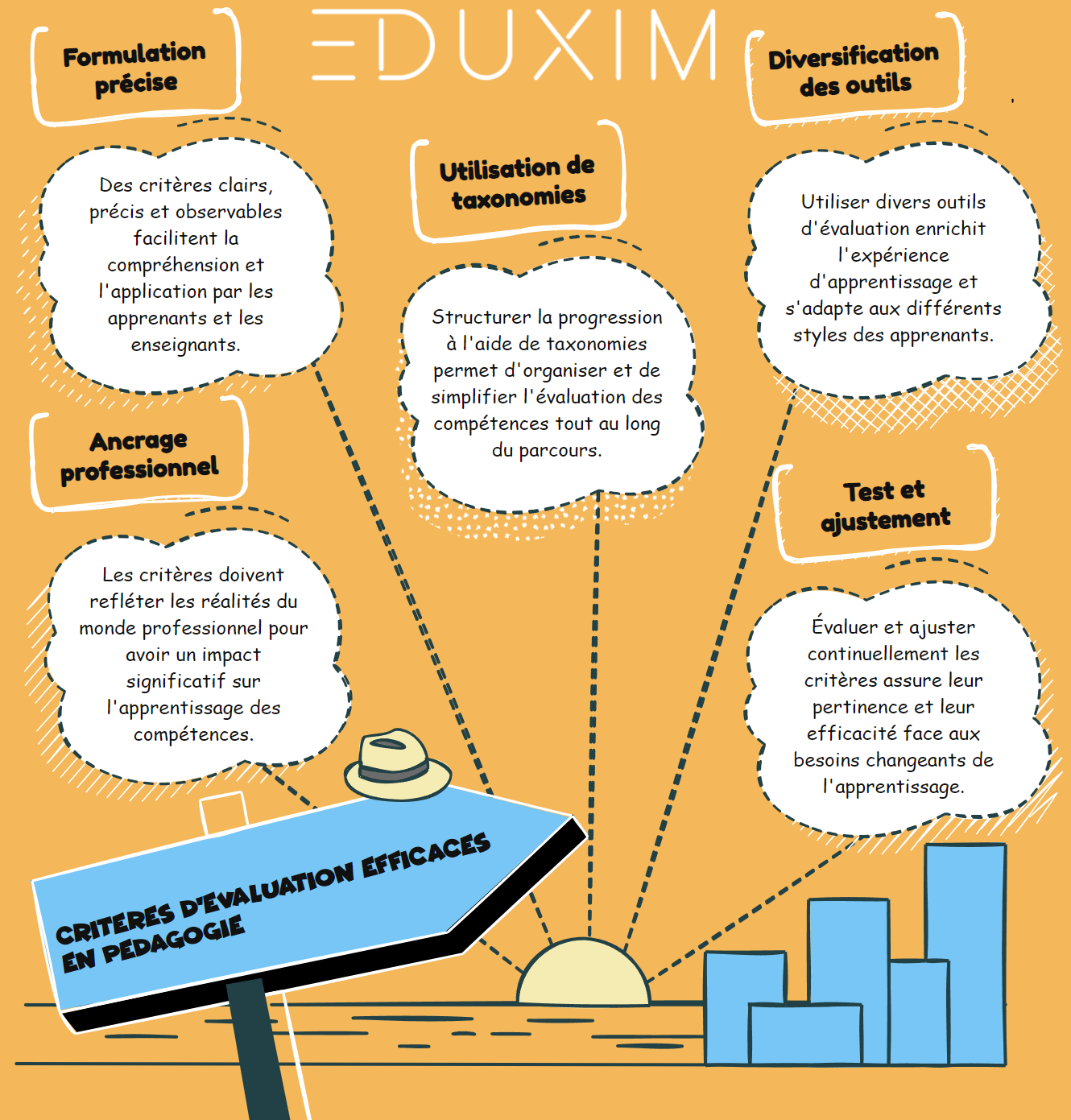

La démarche que nous avons présentée met l’accent sur plusieurs principes clés :

- L’ancrage des critères dans les réalités professionnelles

- La formulation précise et observable

- L’utilisation de taxonomies pour structurer la progression

- La diversification des outils d’évaluation

- Le test et l’ajustement continu

- L’implication active des apprenants

Cette approche dynamique et collaborative de l’évaluation constitue un changement de paradigme par rapport aux pratiques traditionnelles. Elle place l’apprentissage au cœur du processus et reconnaît que l’évaluation n’est pas la fin du chemin, mais un jalon essentiel dans le développement continu des compétences.

Dans notre prochain article, nous explorerons comment structurer efficacement votre référentiel de compétences en lien avec vos cours et les exigences du RNCP, pour garantir une cohérence globale de votre dispositif de formation.

Pour aller plus loin

Pour vous accompagner dans l’élaboration et l’amélioration de vos critères d’évaluation, Eduxim met à votre disposition :

- Un modèle de grille critériée adaptable à vos besoins spécifiques

- Un guide méthodologique sur l’évaluation authentique des compétences

- Des ateliers de formation pour vos équipes pédagogiques

N’hésitez pas à nous contacter pour échanger sur vos besoins spécifiques ou pour obtenir ces ressources